AIの時代において、コンピューティングの単位はもはやサーバーの数だけで測られるものではありません。相互接続されたGPU、CPU、メモリ、ストレージ、そしてラック内の複数ノードにまたがるこれらのリソースが、現代の人工知能を構成しています。 このインフラストラクチャには、高速かつ低遅延のネットワークファブリック、そして各データセンター環境において最適なパフォーマンスと効率性を維持するための、慎重に設計された冷却技術と電力供給が求められます。Supermicro、急速に進化する生成AIや大規模言語モデル(LLM)向けに、エンドツーエンドのAIデータセンターソリューションを提供します。

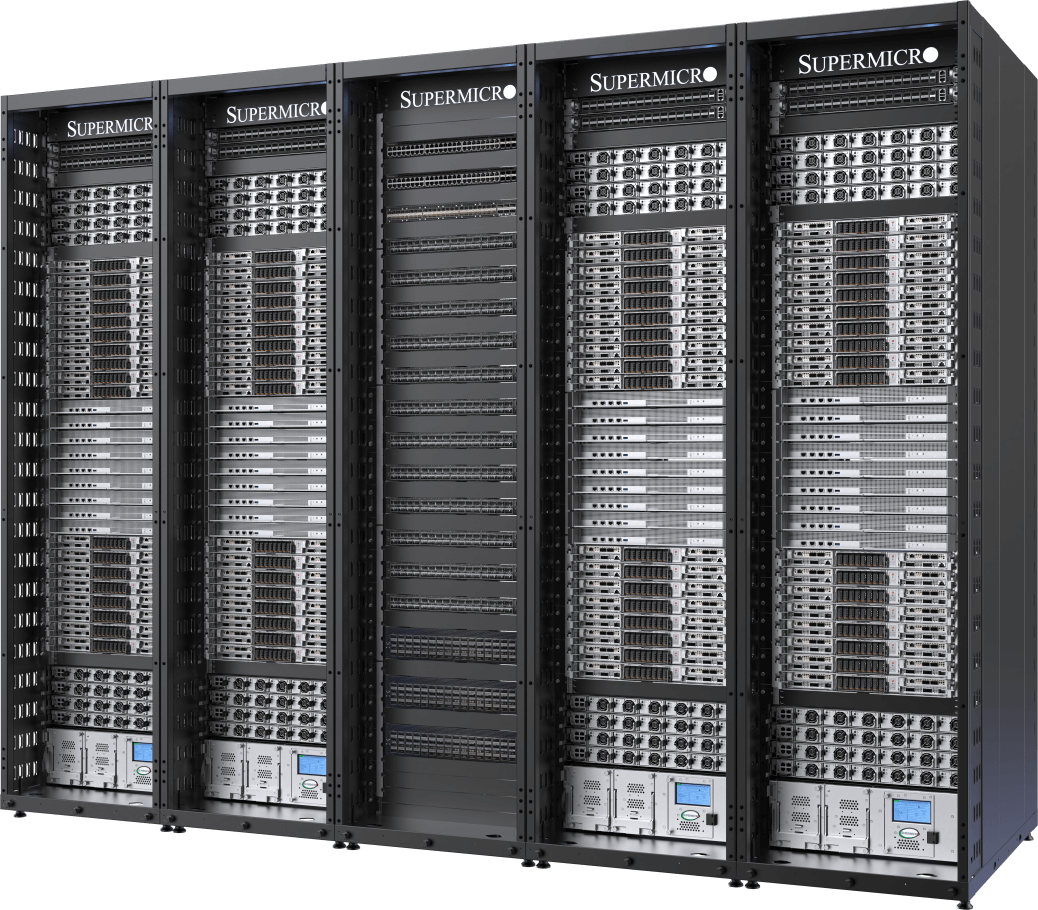

規模に応じた完全な統合

フルラックおよびクラスタの設計・製造。 5,000 ラック 月あたり

オンサイトサービスによるテスト、検証、デプロイ

実証済みのL11、L12試験プロセスにより、出荷前に運用の有効性と効率を徹底的に検証します。

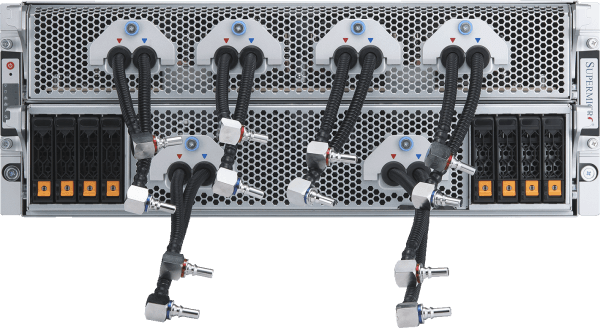

液冷/空冷

GPUおよびCPUコールドプレート、冷却分配ユニット、マニホールドを備えた完全統合型液冷または空冷ソリューション

供給と在庫管理

ワンストップ・ショップにより、完全一体型ラックを迅速かつオンタイムで提供し、ソリューション導入までの時間を短縮します。

このフルターンキー・データセンター・ソリューションは、ミッションクリティカルな企業ユースケースの納期を短縮し、従来はスーパーコンピューティングの集中的な設計チューニングと時間のかかる最適化によってのみ達成可能であった大規模クラスタ構築の複雑さを解消します。

水冷式NVIDIA HGX B200AIクラスタ

5ラックで最大32個のNVIDIA HGX B200 8-GPU、4U液冷システム(256 GPU)を使用可能

- 256個のNVIDIA B200 GPUを1つのスケーラブルなユニット(5ラック)に搭載し、AIトレーニングと推論性能の最高峰を展開

- Supermicro 、250kW容量のラック内冷却剤分配ユニット(CDU)を搭載し、冗長電源ユニット(PSU)とデュアルホットスワップ対応ポンプを備えております。

- 45TBのHBM3eメモリを1つのスケーラブル・ユニットに搭載

- 400Gb/s NVIDIASpectrum™-XEthernetまたはNVIDIA Quantum-2 InfiniBandによるスケールアウト

- 業界をリードする並列ファイルシステムオプションを備えたカスタマイズ可能なデータストレージファブリック

- NVIDIA NIMマイクロサービスを含むNVIDIA AI Enterprise Platformのサポート

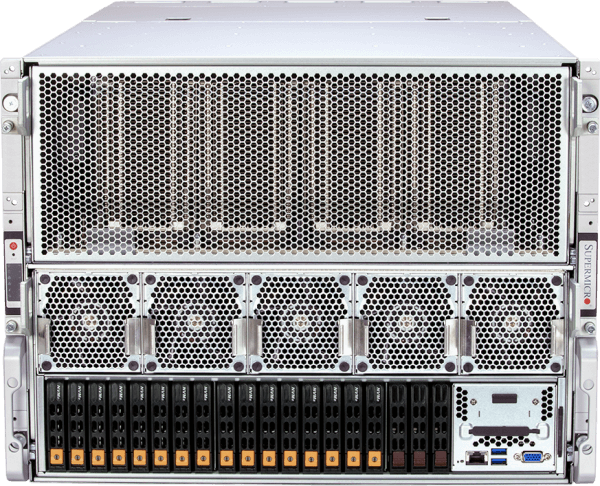

計算ノード

空冷NVIDIA HGX B200 AIクラスタ

32 NVIDIA HGX B200 8-GPU、10U空冷システム(256 GPU)を9ラックに搭載

- 熱的に最適化された新しい空冷システム・プラットフォームによる、業界をリードする実績あるアーキテクチャ

- 45TBのHBM3eメモリを1つのスケーラブル・ユニットに搭載

- 400Gb/s NVIDIASpectrum-XEthernetまたはNVIDIA Quantum-2 InfiniBandによるスケールアウト

- 業界をリードする並列ファイルシステムオプションを備えたカスタマイズ可能なデータストレージファブリック

- NVIDIA NIMマイクロサービスを含むNVIDIA AI Enterprise Platformのサポート

計算ノード

NVIDIA GB200 NVL72

1台のラックで液冷エクサスケール・コンピューティングを実現

- 72x NVIDIA Blackwell B200 GPUは、HBM3eメモリの巨大なプール(ラックあたり13.5TB)を備えた1つのGPUとして動作します。

- 9×NVLinkスイッチ、コンピュートトレイあたり4ポートで72 GPUを接続し、1.8TB/秒のGPU間相互接続を実現

- Supermicro 、250kW容量のラック内冷却剤分配ユニット(CDU)を搭載し、冗長電源ユニット(PSU)とデュアルホットスワップ対応ポンプを備えております。

- Supermicroンドツーエンド液体冷却ソリューションと包括的なオンサイト導入サービス

- NVIDIABlueField®-3SuperNIC、Spectrum-X、Quantum-2、次世代800Gb/秒ネットワーキング・プラットフォームなど、スケーリングに対応した先進ネットワーキング・テクノロジーに対応

計算トレイ

- ARS-121GL-NBO-LCC

(単品販売ではありません。)

業界をリードする液冷AIクラスタ

32 NVIDIA HGX H100/H200 8-GPU、4U液冷システム(256 GPU)を5ラックに搭載

- Supermicroカスタム液体冷却ソリューションにより、コンピューティング密度を倍増させ、データセンターの電力コストを最大40%削減いたします。

- 256基のNVIDIA H100/H200 GPUを1つのスケーラブルなユニットに搭載

- 20TBのHBM3とH100、または36TBのHBM3eとH200を1台のスケーラブル・ユニットに搭載

- 各GPUへの1:1ネットワーキングにより、NVIDIA GPUDirect RDMAおよびストレージが可能になり、最大数兆のパラメータを持つ大規模言語モデルのトレーニングが可能になります。

- 業界をリードする並列ファイルシステムオプションを備えたカスタマイズ可能なAIデータパイプラインストレージファブリック

- NVIDIA Quantum-2 InfiniBandおよびSpectrum-X Ethernetプラットフォームに対応

- NVIDIA NIMマイクロサービスを含むNVIDIA AI Enterprise Platformの認定を取得しています。

計算ノード

実績あるデザイン

32 NVIDIA HGX H100/H200 8-GPU、8U空冷システム(256 GPU)を9ラックに搭載

- 大規模なAIインフラ展開のための業界をリードする実績あるアーキテクチャ

- 256基のNVIDIA H100/H200 GPUを1つのスケーラブルなユニットに搭載

- 20TBのHBM3とH100、または36TBのHBM3eとH200を1台のスケーラブル・ユニットに搭載

- 各GPUへの1:1ネットワーキングにより、NVIDIA GPUDirect RDMAおよびストレージが可能になり、最大数兆のパラメータを持つ大規模言語モデルのトレーニングが可能になります。

- 業界をリードする並列ファイルシステムオプションを備えたカスタマイズ可能なAIデータパイプラインストレージファブリック

- NVIDIA Quantum-2 InfiniBandおよびSpectrum-X Ethernetプラットフォームに対応

- NVIDIA NIMマイクロサービスを含むNVIDIA AI Enterprise Platformの認定を取得しています。

計算ノード