Supermicro、AI、機械学習、HPCに最適な 画期的なUniversal GPUシステムを発表

カリフォルニア州サンノゼ、2022 年 3 月 24 日 -- Super Micro Computer, Inc. (Nasdaq: SMCI)は、ハイパフォーマンスコンピューティング、ストレージ、ネットワーク、グリーンコンピューティングテクノロジーのグローバルリーダーです。同社は、大規模なGPUシステムの展開を簡素化できる革新的な製品となる「Universal GPU」を発表しました。Universal GPUサーバーは、今後発表される将来のテクノロジーのサポートも可能にする、業界最先端の設計で、同社のリソース・セービング・アーキテクチャと共に、究極の柔軟性を提供します。

Universal GPU のシステムアーキテクチャは、数種類のGPUフォームファクター、CPUの選択、ストレージ、ネットワークオプションから構成でき、最新のテクノロジーを組み合わせて最適化し、独自の構成と高い拡張性を持つシステムとして提供されます。拡張性のあるこのシステムは、各企業特有の人工知能(AI)、機械学習(ML)、ハイパフォーマンスコンピューティング(HPC)アプリケーションの要件に合わせて最適化できます。次世代のCPUやGPUの温度要件にも対応可能な次世代コンピューティング環境を求めるお客様に最適です。

Supermicro の社長兼最高責任者(CEO)であるチャールズ・リアン(Charles Liang)は、次のように述べています。「Supermicro の Universal GPU サーバーは、業界水準とデータセンターインフラストラクチャの基準を刷新する、画期的な製品となります。将来を見据えた強力なモジュール式プラットフォームは、企業のCTOやIT管理者が新たなシステムを展開する際の計画における基本ルールを変革します。この製品は柔軟で革新的なシステム設計となっており、最良のテクノロジーと組み合わせることで、大規模で迅速な展開を可能にします。」

Universal GPU プラットフォームは、まず、第3世代AMD EPYC™ 7003プロセッサーと、AMD MI250 GPU または NVIDIA A100 Tensor Core 4-GPU のいずれかを組み合わせたシステム、さらに、第3世代 インテル® Xeon® スケーラブル・プロセッサーとNVIDIA A100 Tensor Core 4-GPU を組み合わせたシステムをサポートする予定です。これらのシステムは、最大 700W クラスの GPU 熱容量にも対応できる設計となっています。

Supermicro Universal GPU プラットフォームは、オープンスタンダード設計に基づいた様々なGPUで動作するように設計されています。ユニバーサルベースボード(UBB)やOCPアクセラレータモジュール(OAM)、PCI-E、プラットフォーム特有のインタフェースなど、それぞれのハードウェア設計標準に準拠しているため、IT管理者は、HPCやAIワークロードに最適なGPUアーキテクチャを選択できます。これにより、多くの企業の厳しい要件を満たすことができ、GPU ソリューションの導入から、検証、運用、そしてアップグレードまでが簡素化されます。さらに、IT管理者はCPUとGPUの適切な組み合わせを容易に選択できるため、お客様にとって最適なシステムを構築できます。

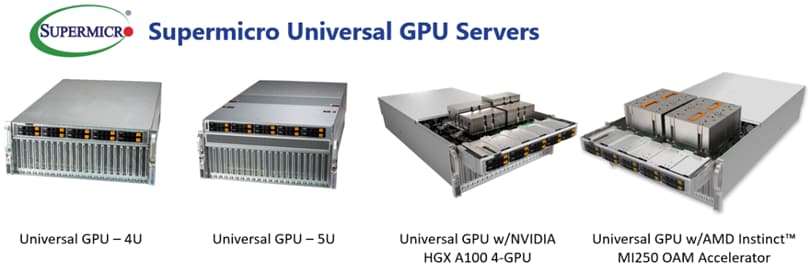

4U、または、5UのUniversal GPUサーバーは、UBB標準に準拠したアクセラレータおよびPCI-E 4.0、またはPCI-E 5.0 を順次利用可能になります。さらに、32 DIMMスロットや、最新のPCI-E規格で接続する幅広いストレージとネットワークのオプションを利用可能です。Supermicro Universal GPUサーバーは、NVIDIA NVLink™ や、AMD Infinity Fabric™/xGMIなどの、非常に高速なGPU間相互接続に対応するSXMまたはOAMフォームファクターのベースボードを使用するか、または、PCI-Eスロットを介したPCI-E GPUカードの直接接続も可能です。現在販売されている主要なCPUおよびGPUプラットフォームをすべてサポートしており、お客様のワークロードやアプリケーションに合致した選択ができます。

このサーバーは、最大限のエアフローを実現する設計がされており、アプリケーションのパフォーマンスを最大化するために必須となる、現在および将来の、より高いTDP(熱設計電力)のCPUやGPUに対応できます。また、Supermicro Universal GPUサーバーは、CPUとGPUにさらなる冷却能力が必要となる場合は、液体冷却オプションの利用も可能です。さらに、モジュラー設計により、サーバーの特定のサブシステムを交換またはアップグレードできるため、システム全体の耐用年数が延び、新しいCPUやGPU技術が切り替わるたびに発生する電子廃棄物を削減できます。

NVIDIA 社のデータセンターコンピューティング製品管理担当シニアディレクターであるParesh Kharya 氏は次のように述べています。 「NVIDIA A100 Tensor Core GPU は、すべての AI アプリケーションと、2,700 を超える HPCアプリケーションを加速します。Supermicroの新しいサーバープラットフォームは、NVIDIA A100を統合し、HPC、AI推論、トレーニング、機械学習などの幅広いワークロードに卓越したパフォーマンスと生産性を誇る強力なシステムを企業に提供します。」

AMD 社のデータセンターGPUおよび高速処理担当コーポレートバイスプレジデントであるBrad McCredie氏は次のように述べています。「AMDは、Supermicroとのパートナーシップを大切にしています。HPC業界のニーズや、演算加速によるデータセンターワークロードの需要に対応する、当社の高度な AMD EPYC CPU と AMD Instinct™ GPU のイノベーションを実証する理想的なプラットフォームとなる Supermicro Universal GPU システムを心待ちにしています。」

Universal GPUに関する詳細は、以下のリンクにてご覧頂けます。

https://www.supermicro.com/ja/products/universal-gpu?utm_content=PR

また、日本時間2022年4月22日午前2時にウェビナー(英語)を開催予定です。参加には以下のリンクにて事前登録(無料)が必要です。

https://www.brighttalk.com/webcast/17278/536388?PR