Máxima densidad

Con 32 sistemas NVIDIA HGX H100/H200 de 8 GPU, 4U y refrigeración líquida (256 GPU) en 5 racks

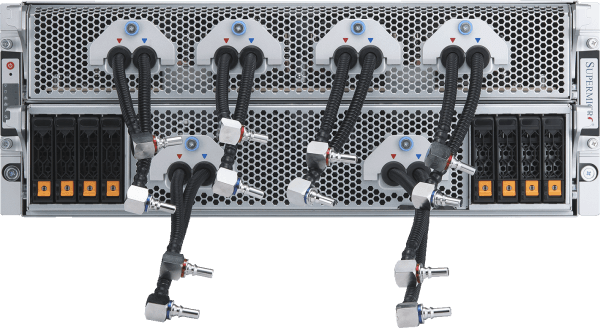

- Duplicación de la densidad de cálculo a través de la solución de refrigeración líquida personalizada de Supermicro con una reducción de hasta el 40% en el coste de electricidad para el centro de datos.

- 256 GPU NVIDIA H100/H200 en una unidad escalable

- 20 TB de HBM3 con H100 o 36 TB de HBM3e con H200 en una unidad escalable

- Conexión en red 1:1 con cada GPU para permitir RDMA y almacenamiento NVIDIA GPUDirect para el entrenamiento de modelos de lenguaje de gran tamaño con hasta billones de parámetros.

- Tejido de almacenamiento de canalización de datos de IA personalizable con opciones de sistemas de archivos paralelos líderes del sector

- Supports NVIDIA Quantum-2 InfiniBand and Spectrum™-X Ethernet platform

- Certified for NVIDIA AI Enterprise Platform including NVIDIA NIM microservices

Nodo informático

Featured Resources