Lieferung in Volumen NVIDIA Blackwell HGX™ B200 Systeme

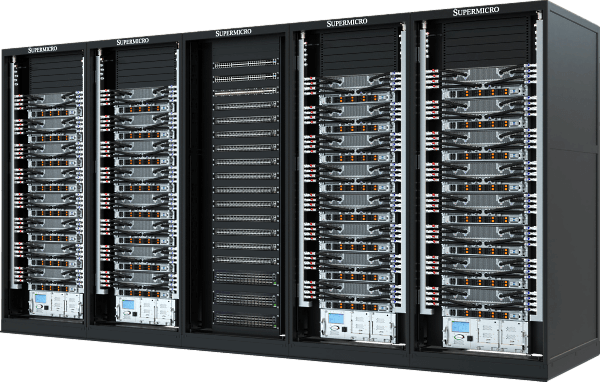

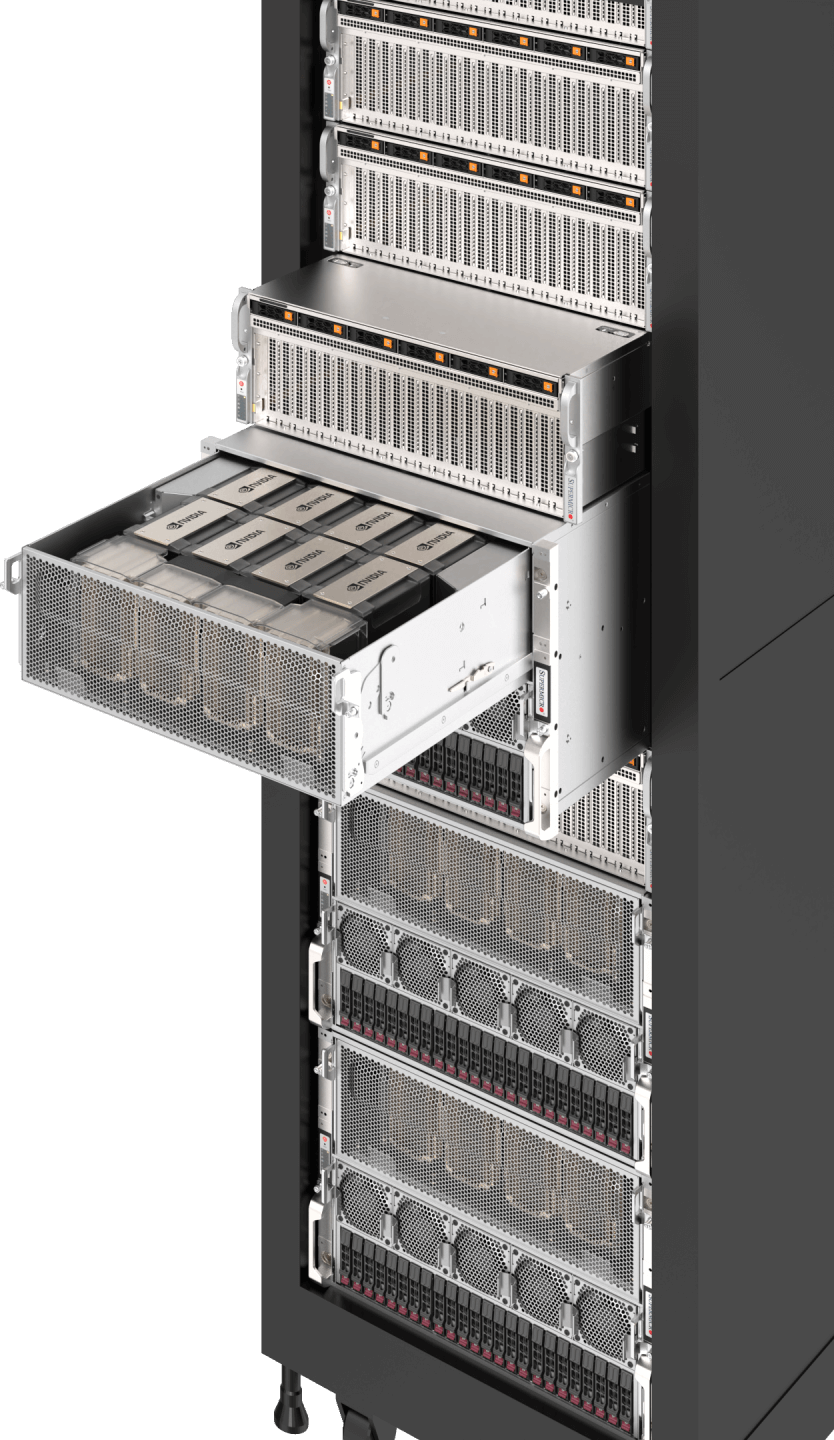

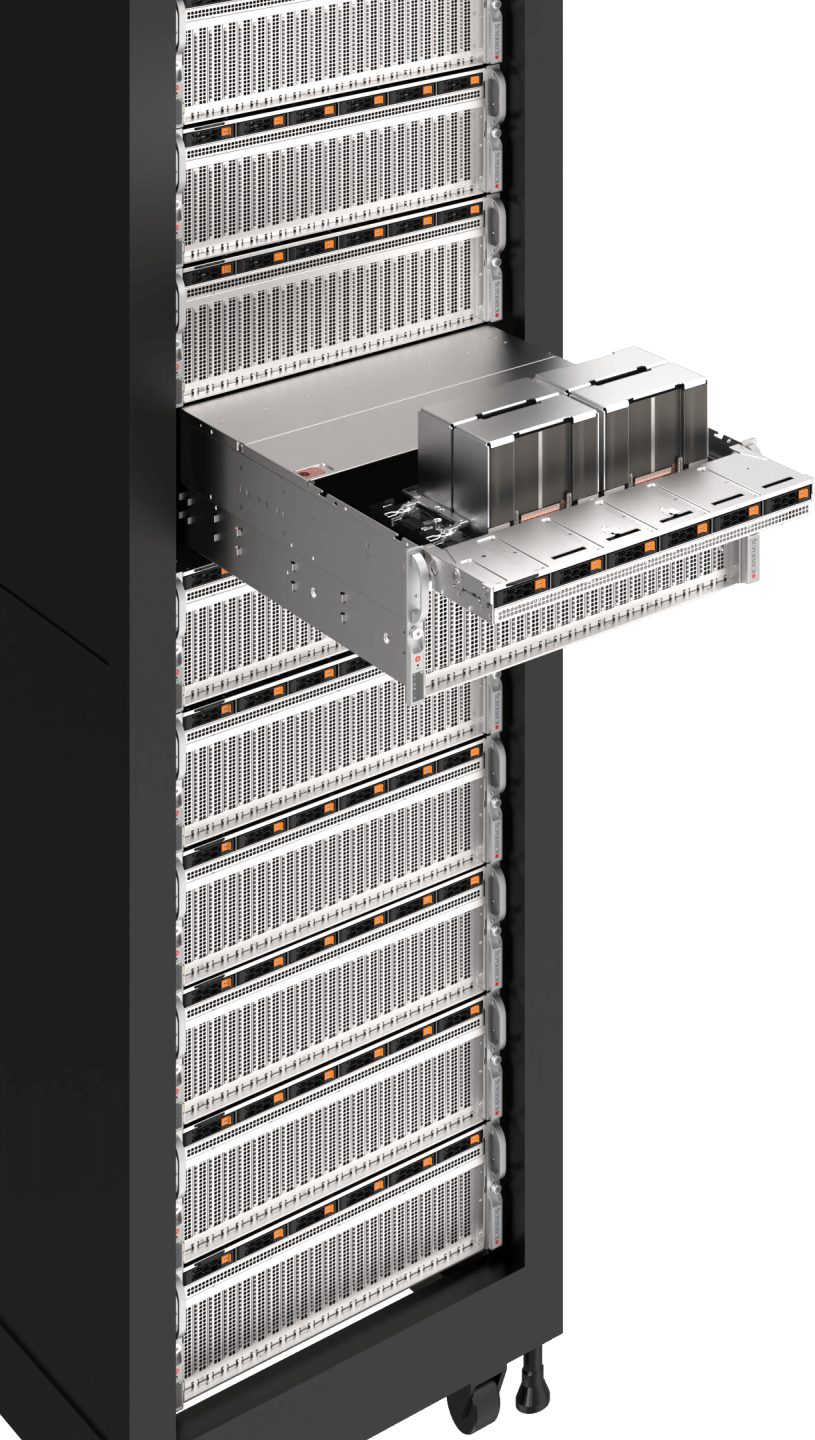

NVIDIA GB200 NVL72 SuperCluster

Der Motor der KI

xAI Koloss

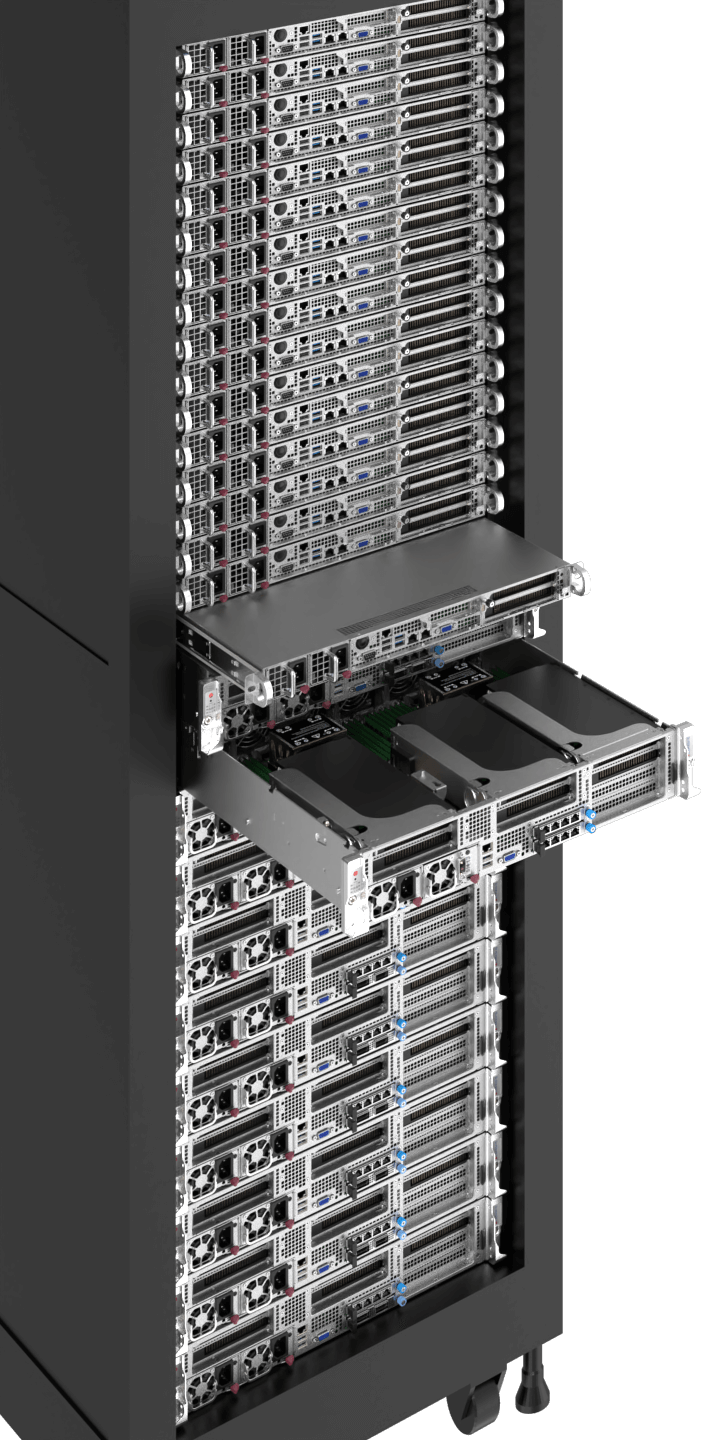

Erschließen Sie das volle Potenzial von KI mit Supermicroinnovativen KI Infrastrukturlösungen. Von groß angelegten Schulungen bis hin zu intelligentem Edge Inferencing - unsere schlüsselfertigen Referenzdesigns rationalisieren und beschleunigen die KI . Ermöglichen Sie Ihren Workloads optimale Leistung und Skalierbarkeit bei gleichzeitiger Optimierung der Kosten und Minimierung der Umweltbelastung. Entdecken Sie eine Welt der Möglichkeiten mit Supermicrovielfältiger Auswahl an KI Lösungen und beschleunigen Sie jeden Aspekt Ihres Geschäfts.

KI-Training und Inferenz in großem Maßstab

Große Sprachmodelle, generatives KI , autonomes Fahren, Robotik

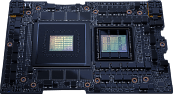

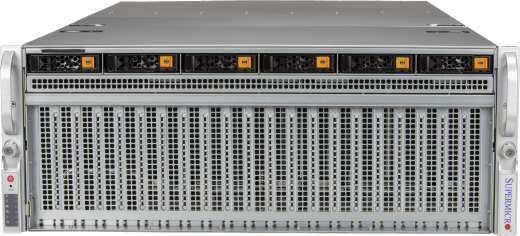

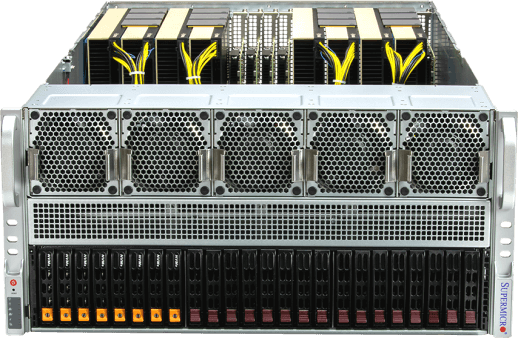

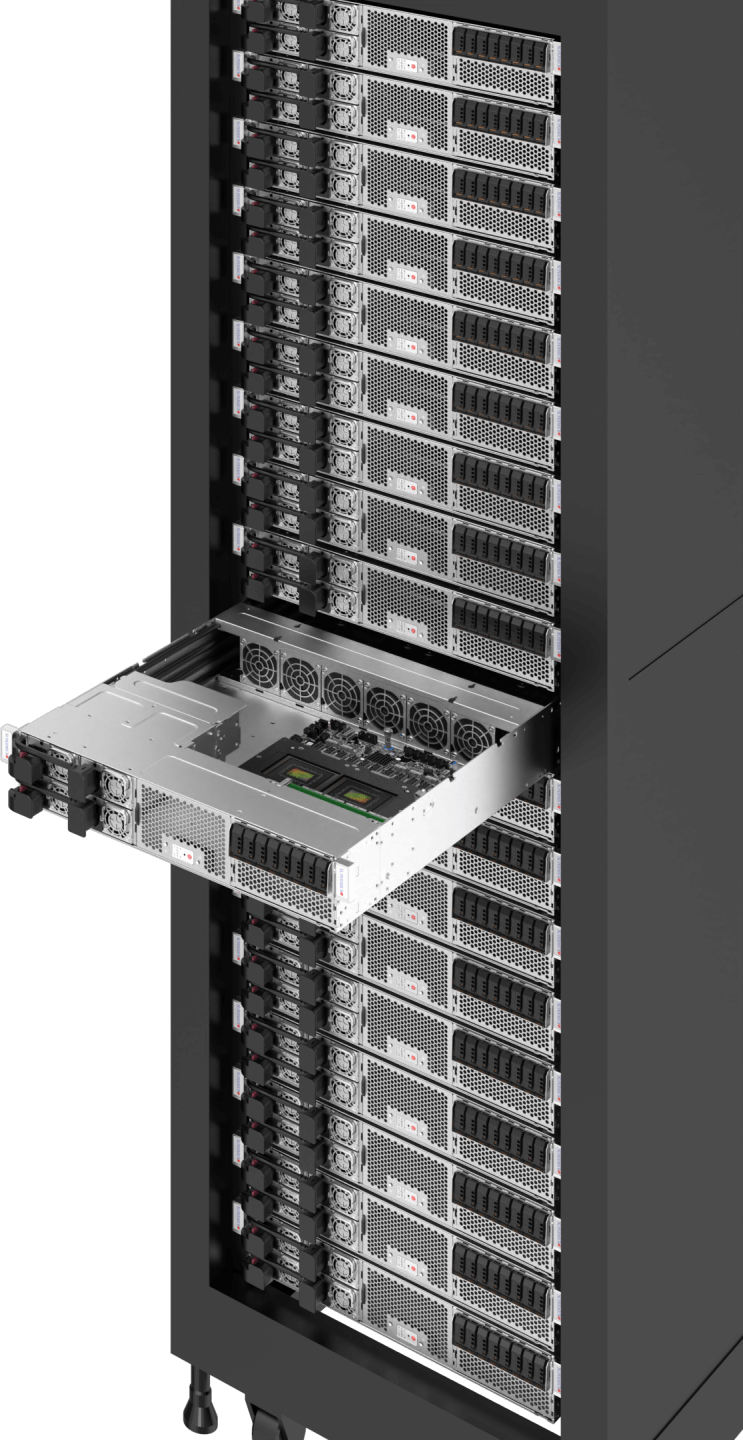

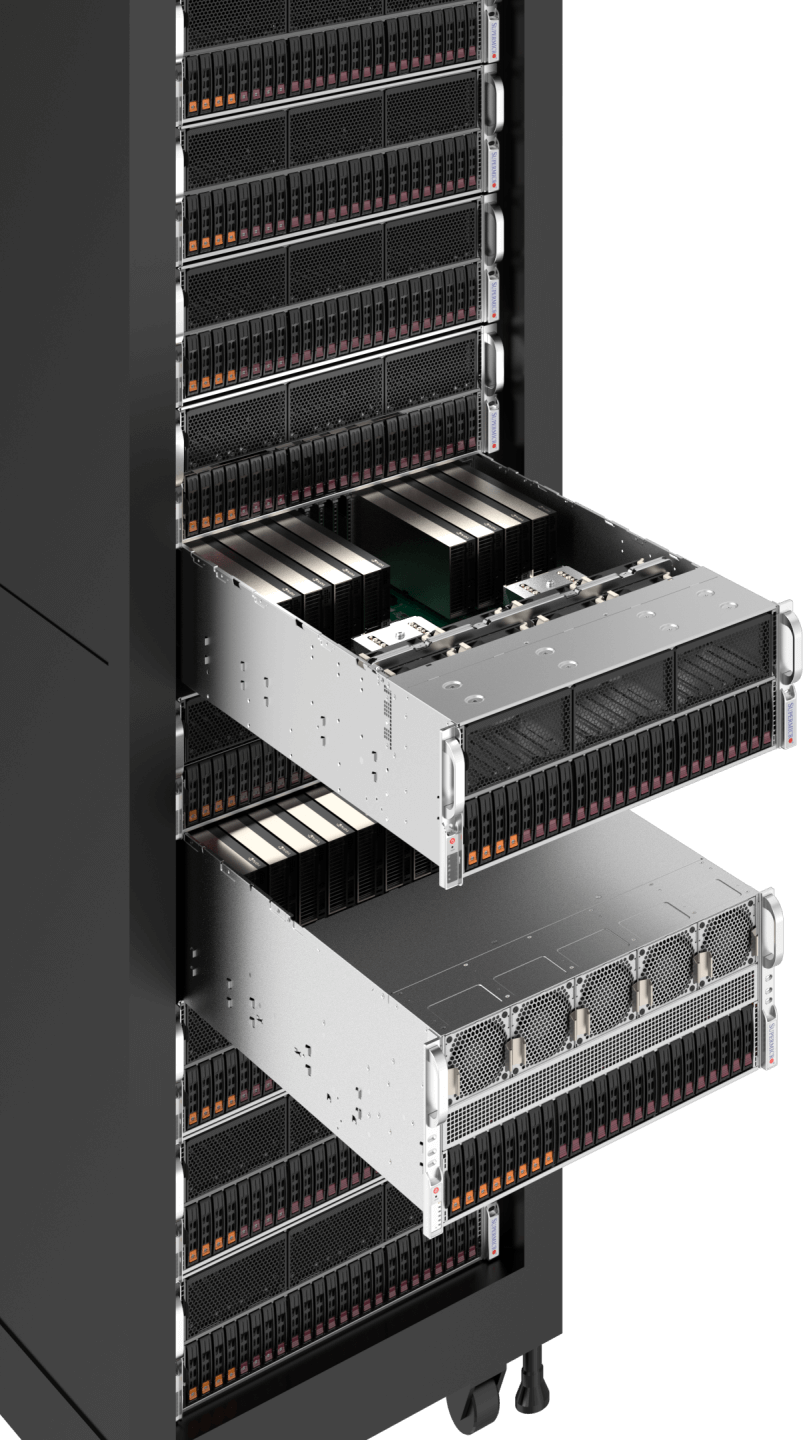

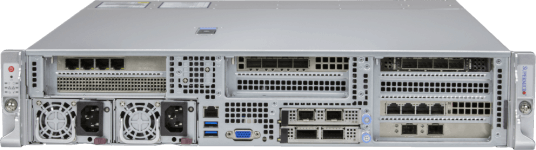

KI in großem Maßstab erfordert Spitzentechnologien zur Maximierung der parallelen Rechenleistung von Grafikprozessoren, um Milliarden, wenn nicht gar Billionen von KI zu verarbeiten, die mit riesigen Datensätzen trainiert werden müssen. Durch den Einsatz der NVIDIA HGX™ B200 und GB200 NVL72 und der schnellsten NVLink® & NVSwitch® GPU-GPU-Verbindungen mit einer Bandbreite von bis zu 1,8 TB/s sowie der schnellsten 1:1-Vernetzung zu jeder GPU für das Node Clustering sind diese Systeme optimiert, um große Sprachmodelle von Grund auf zu trainieren und sie Millionen von gleichzeitigen Benutzern zur Verfügung zu stellen. Wir vervollständigen den Stack mit All-Flash-NVMe für eine schnelle KI und bieten vollständig integrierte Racks mit Flüssigkühlungsoptionen, um eine schnelle Bereitstellung und ein reibungsloses KI zu gewährleisten.

Workload-Größen

- Extra groß

- Groß

- Mittel

- Lagerung

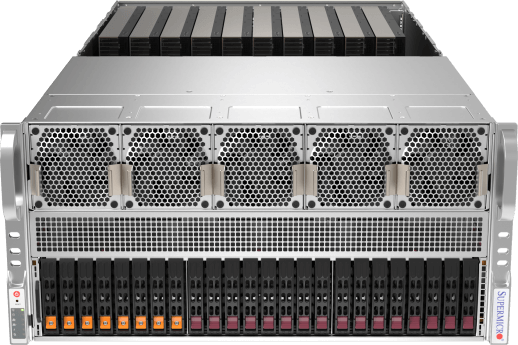

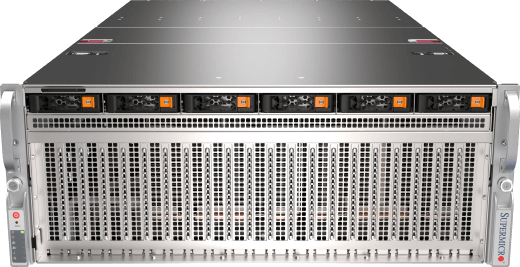

Flüssigkeitsgekühlte NVIDIA HGX B200 Systeme und Racks

NVIDIA GB200 NVL72 mit Supermicro

10U System mit NVIDIA HGX B200 8-GPU und 8U System mit HGX H200 8-GPU

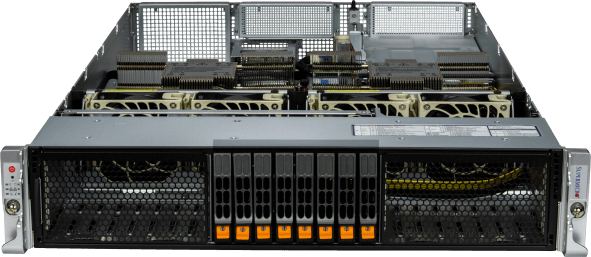

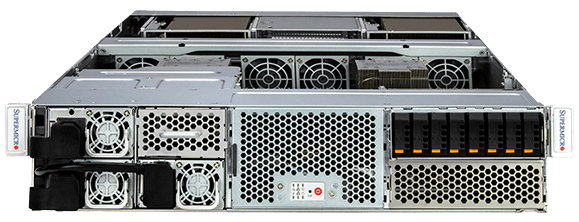

4U-4-GPU-System

NVMe-Flash im Petabyte-Maßstab

Festplattenspeicher im Petabyte-Bereich

Ressourcen

KI

Technische Simulation, Wissenschaftliche Forschung, Genomische Sequenzierung, Entdeckung von Medikamenten

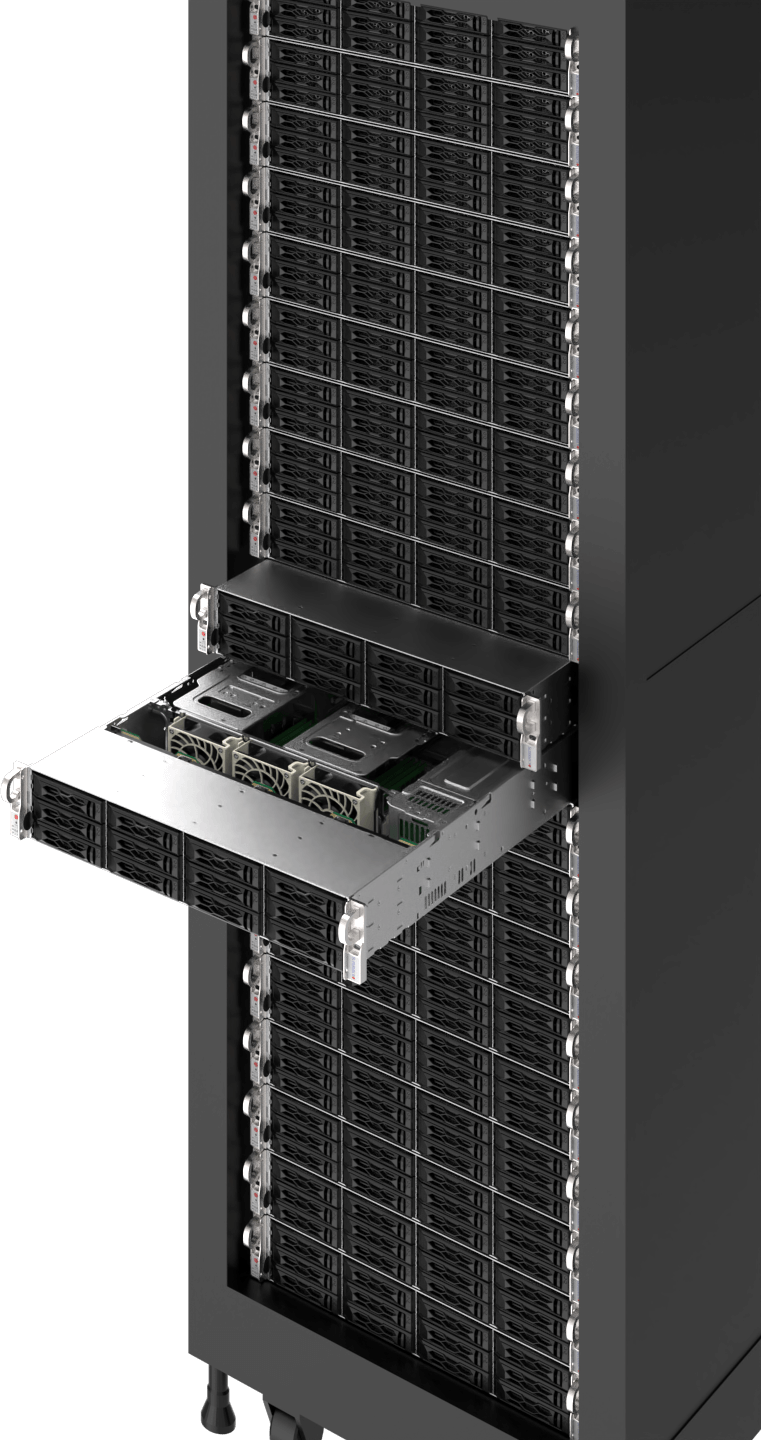

Immer mehr HPC-Workloads nutzen Algorithmen des maschinellen Lernens und GPU-beschleunigtes paralleles Rechnen, um schnellere Ergebnisse zu erzielen und die Zeit bis zur Entdeckung für Wissenschaftler, Forscher und Ingenieure zu verkürzen. Viele der schnellsten Supercomputing-Cluster der Welt nutzen jetzt die Vorteile von GPUs und der Leistung von KI.

HPC-Workloads erfordern in der Regel datenintensive Simulationen und Analysen mit massiven Datensätzen und Präzisionsanforderungen. GPUs wie NVIDIAs H100/H200 bieten eine beispiellose Double-Precision-Leistung mit 60 Teraflops pro GPU. Supermicrohochflexible HPC-Plattformen ermöglichen eine hohe Anzahl von GPUs und CPUs in einer Vielzahl von dichten Formfaktoren mit Rack-Scale-Integration und Flüssigkeitskühlung.

Workload-Größen

- Groß

- Mittel

4U 4-GPU System oder 8U 8-GPU System

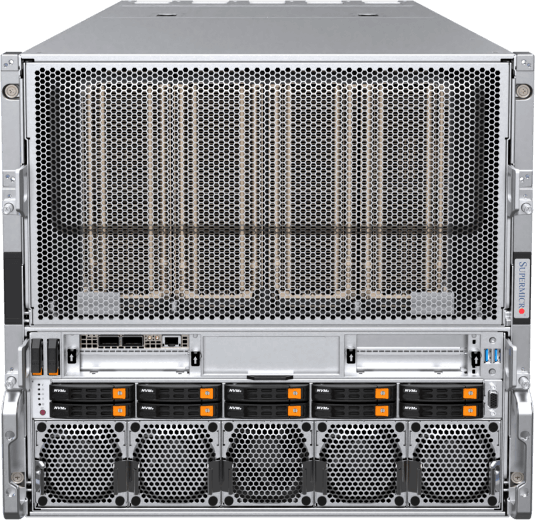

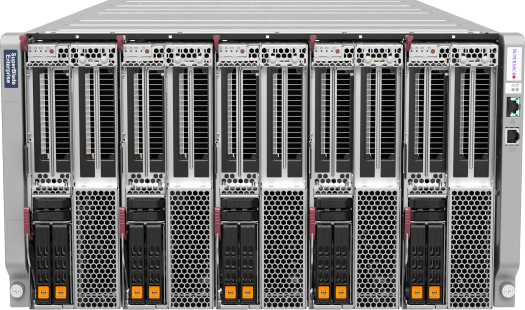

8U SuperBlade®

4U/5U 8-10 GPU PCIe

1U Grace Hopper System

Ressourcen

KI-Inferenz und Schulung für Unternehmen

Generative KI , KI Dienste/Applikationen, Chatbots, Empfehlungssysteme, Geschäftsautomatisierung

Der Aufstieg der generativen KI wurde als die nächste Grenze für verschiedene Branchen erkannt, von der Technologie bis zum Bankwesen und den Medien. Der Wettlauf um die Einführung von KI hat begonnen, um Innovationen zu fördern, die Produktivität deutlich zu steigern, Abläufe zu rationalisieren, datengestützte Entscheidungen zu treffen und das Kundenerlebnis zu verbessern.

Ob KI Anwendungen und Geschäftsmodelle, intelligente, menschenähnliche Chatbots für den Kundenservice oder KI zur Co-Pilotierung von Codegenerierung und Inhaltserstellung - Unternehmen können offene Frameworks, Bibliotheken und vortrainierte KI nutzen und sie für spezielle Anwendungsfälle mit ihrem eigenen Datensatz feinabstimmen. Wenn Unternehmen KI einführen, bieten Supermicroverschiedene GPU-optimierte Systeme eine offene modulare Architektur, Herstellerflexibilität und einfache Einsatz- und Upgrade-Pfade für sich schnell entwickelnde Technologien.

Workload-Größen

- Extra groß

- Groß

- Mittel

4U/5U 8-10 GPU PCIe

6U SuperBlade®

2U MGX-System

2U Grace MGX-System

Ressourcen

Visualisierung & Gestaltung

Echtzeit-Zusammenarbeit, 3D-Design, Spieleentwicklung

Die höhere Wiedergabetreue von 3D-Grafiken und KI Anwendungen durch moderne Grafikprozessoren beschleunigt die industrielle Digitalisierung und verändert Produktentwicklungs- und Designprozesse, die Fertigung und die Erstellung von Inhalten durch realitätsgetreue 3D-Simulationen, um eine neue Qualität, unendliche Iterationen ohne Opportunitätskosten und eine kürzere Markteinführungszeit zu erreichen.

Bauen Sie eine virtuelle Produktionsinfrastruktur im großen Maßstab auf, um die industrielle Digitalisierung zu beschleunigen - mit den vollständig integrierten Lösungen von Supermicro, einschließlich der 4U/5U 8-10 GPU-Systeme, einer NVIDIA OVX™-Referenzarchitektur, die für NVIDIA Omniverse Enterprise mit Universal Scene Description (USD)-Anschlüssen optimiert ist, sowie NVIDIA-zertifizierten Rackmount-Servern und Multi-GPU-Workstations.

Workload-Größen

- Groß

- Mittel

Ressourcen

Bereitstellung von Inhalten & Virtualisierung

Content Delivery Networks (CDNs), Transkodierung, Komprimierung, Cloud Gaming/Streaming

Videoübertragungen machen nach wie vor einen erheblichen Teil des heutigen Internetverkehrs aus. Da Anbieter von Streaming-Diensten zunehmend Inhalte in 4K und sogar 8K oder Cloud-Gaming mit höherer Bildwiederholrate anbieten, ist die GPU-Beschleunigung mit Medien-Engines ein Muss, um die mehrfache Durchsatzleistung für Streaming-Pipelines zu ermöglichen und gleichzeitig die erforderliche Datenmenge mit besserer visueller Wiedergabetreue zu reduzieren, dank neuester Technologien wie AV1-Codierung und -Decodierung.

SupermicroMulti-Node- und Multi-GPU-Systeme, wie z.B. das 2U 4-Node BigTwin® System, erfüllen die strengen Anforderungen der modernen Videobereitstellung. Jeder Knoten unterstützt die NVIDIA L4 GPU mit der Fähigkeit, viel PCIe Gen5 Speicher und Netzwerkgeschwindigkeit zu bieten, um die anspruchsvolle Datenpipeline für Content-Delivery-Netzwerke zu betreiben.

Workload-Größen

- Groß

- Mittel

- Klein

Ressourcen

Rand KI

Edge Video Transcoding, Edge Inference, Edge Training

Branchenübergreifend investieren Unternehmen, deren Mitarbeiter und Kunden an Edge-Standorten arbeiten - in Städten, Fabriken, Einzelhandelsgeschäften, Krankenhäusern und vielen anderen - zunehmend in den Einsatz von KI am Edge. Durch die Verarbeitung von Daten und die Nutzung von KI und ML-Algorithmen am Edge überwinden Unternehmen Bandbreiten- und Latenzbeschränkungen und ermöglichen Echtzeitanalysen für eine zeitnahe Entscheidungsfindung, eine vorausschauende Betreuung und personalisierte Dienste sowie optimierte Geschäftsabläufe.

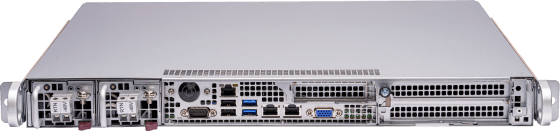

Speziell entwickelte, umgebungsoptimierte Supermicro Edge KI Server mit verschiedenen kompakten Formfaktoren bieten die erforderliche Leistung für niedrige Latenzzeiten, eine offene Architektur mit vorintegrierten Komponenten, vielfältige Hardware- und Software-Stack-Kompatibilität sowie Datenschutz- und Sicherheitsfunktionen, die für komplexe Edge-Implementierungen erforderlich sind, direkt nach dem Auspacken.

Workload-Größen

- Extra groß

- Groß

- Mittel

- Klein

Hyper

Kompakt

Multi-GPU-Edge-Server mit geringer Tiefe

Lüfterlos

Ressourcen

Breitestes Portfolio an KI Systemen

Skalierter Einsatz von NVIDIA Omniverse™

COMPUTEX 2024 CEO-Keynote