Supermicro präsentiert die branchenweit ersten hochskalierbaren KI- und Machine Learning-Systeme auf Basis der neuesten Generation von CPUs und NVIDIA Tesla V100 mit NVLink GPUs für überragende Leistung und Dichte

TAIPEI, Taiwan, 30. Mai 2018 /PRNewswire/ -- Super Micro Computer, Inc: (NASDAQ: SMCI), ein weltweit führendes Unternehmen im Bereich Enterprise Computing, Speicher-, Netzwerklösungen und Green Computing-Technologie, gab heute bekannt, dass es auf der GPU Technology Conference (GTC) Taiwan 2018, die vom 30. bis zum 31. Mai im Taipei Marriott Hotel stattfinden wird, die branchenweit größte Auswahl an GPU-Serverplattformen präsentiert, die NVIDIA® Tesla® V100 PCI-E und V100 SXM2 Tensor Core GPU-Beschleuniger unterstützen.

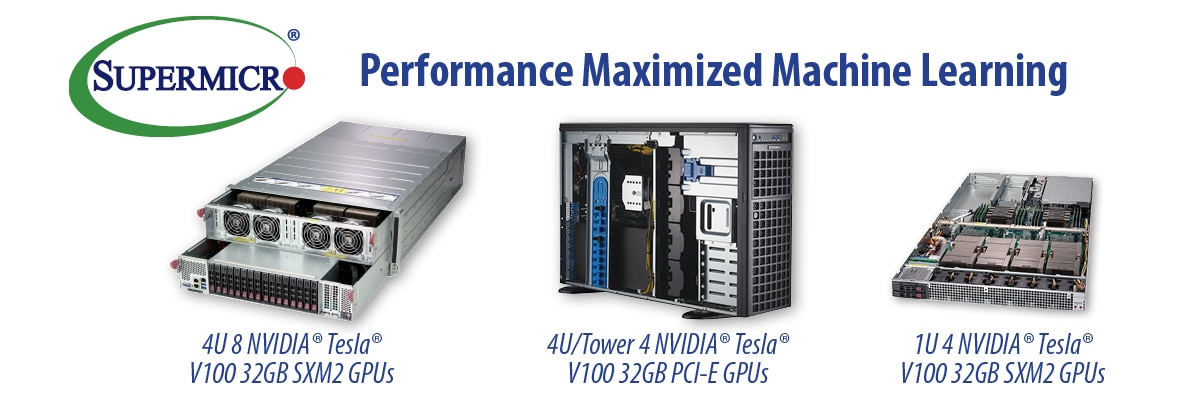

Das neue 4-HE-System von Supermicro mit NVIDIA NVLink™ Interconnect-Technologie der nächsten Generation ist für maximale Beschleunigung von hoch-parallelen Anwendungen wie künstliche Intelligenz (KI), Deep Learning, selbstfahrende Autos, intelligente Städte, Gesundheitswesen, Big Data, High Performance Computing (HPC), virtuelle Realität und viele weitere auf maximale Leistung optimiert. SuperServer 4029GP-TVRT, ein Teil der NVIDIA HGX-T1-Klasse von GPU-beschleunigten Serverplattformen, unterstützt acht NVIDIA Tesla V100 32 GB SXM2 GPU-Beschleuniger mit maximaler GPU-zu-GPU-Bandbreite für Cluster- und Hyperscale-Anwendungen. Das System verfügt über die neueste NVIDIA NVLink-Technologie mit mehr als der fünffachen Bandbreite von PCI-E 3.0 und über unabhängige GPU- und CPU-Thermalzonen, um eine kompromisslose Leistung und Stabilität unter den anspruchsvollsten Workloads zu gewährleisten.

„Bei ersten internen Benchmark-Tests konnte unser 4029GP-TVRT-System 5.188 Bilder pro Sekunde auf ResNet-50 und 3.709 Bilder pro Sekunde auf InceptionV3-Workloads erzielen", sagte Charles Liang, Präsident und CEO von Supermicro. „Wir sehen auch sehr beeindruckende, beinahe lineare Leistungssteigerungen bei der Skalierung auf mehrere Systeme mit GPU Direct RDMA. Dank unseren neuesten Innovationen, die die neuen NVIDIA V100 32 GB PCI-E- und V100 32 GB SXM2-GPUs mit doppeltem Speicher in leistungsoptimierten 1-HE- und 4-HE-Systemen mit NVLink der nächsten Generation enthalten, können unsere Kunden ihre Anwendungen und Innovationen beschleunigen, um die komplexesten und anspruchsvollsten Probleme zu lösen".

„Unternehmenskunden profitieren von einem neuen Level der Rechenleistung mit dichteoptimierten Supermicro Servern, die für NVIDIA Tesla V100 32 GB Tensor Core GPUs ausgelegt sind", sagte Ian Buck, Vizepräsident und Geschäftsführer of Accelerated Computing bei NVIDIA. „Der doppelte Arbeitsspeicher mit V100 ermöglicht um bis zu 50 Prozent schnellere Ergebnisse bei komplexen Deep Learning- und wissenschaftlichen Anwendungen und verbessert die Produktivität der Entwickler, da die Notwendigkeit der Speicheroptimierung minimiert wird."

Supermicro GPU-Systeme unterstützen auch den hocheffizienten Tesla P4, der entwickelt wurde, um Inferenz-Workloads in jedem Scale-Out-Server zu beschleunigen. Die hardwarebeschleunigte Transcode-Engine in Tesla P4 liefert 35 HD-Videostreams in Echtzeit und ermöglicht die Integration von Deep Learning in die Videotranskodierungs-Pipeline, um eine neue Klasse von intelligenten Videoanwendungen zu ermöglichen. Da Deep Learning wie kein anderes Rechenmodell in der Geschichte unsere Welt prägt, werden tiefere und komplexere neuronale Netze auf exponentiell größeren Datenmengen trainiert. Um eine hohe Reaktionszeit zu erreichen, werden diese Modelle auf leistungsstarken Supermicro GPU-Servern eingesetzt, um einen maximalen Durchsatz für Inferenz-Workloads zu erzielen.

Supermicro stellt die NVIDIA SCX-E3-Klasse der GPU-beschleunigten Serverplattformen vor, das leistungsoptimierte 4-HE-SuperServer 4029GR-TRT2-System, das bis zu 10 PCI-E NVIDIA Tesla V100-Beschleuniger mit innovativem und GPU-optimiertem Supermicro Single Root Complex-PCI-E-Design unterstützen kann, was die GPU-Peer-to-Peer-Kommunikation deutlich verbessert. Für eine noch höhere Dichte unterstützt der SuperServer 1029GQ-TRT bis zu vier NVIDIA Tesla V100 PCI-E GPU-Beschleuniger in nur 1 HE Rackspace und der neue SuperServer 1029GQ-TVRT unterstützt vier NVIDIA Tesla V100 SXM2 32 GB GPU-Beschleuniger in 1 HE. Die beiden 1029GQ-Server gehören zur NVIDIA SCX-E2-Klasse der GPU-beschleunigten Serverplattformen.

Mit der Konvergenz von Big Data-Analyselösungen und Machine Learning, den neuesten NVIDIA GPU-Architekturen und verbesserten Algorithmen für Machine Learning erfordern Deep Learning-Anwendungen die Rechenleistung mehrerer GPUs, die leistungsfähig und effektiv kommunizieren müssen, um das GPU-Netzwerk zu erweitern. Das Single-Root-GPU-System von Supermicro sorgt für eine effiziente Kommunikation mehrerer NVIDIA GPUs, um die mit dem NCCL P2PBandwidthTest gemessenen Latenzzeiten zu minimieren und den Durchsatz zu maximieren.

Umfassende Informationen zu den Produktreihen der Supermicro NVIDIA GPU-Systeme finden Sie unter https://www.supermicro.com/products/nfo/gpu.cfm.